Con su capacidad para procesar enormes cantidades de datos, la Inteligencia Artificial (IA) es una herramienta importante para los gobiernos en su búsqueda por brindar servicios centrados en los ciudadanos a todos los sectores de la sociedad.

Esto se ha vuelto aún más evidente en el último año y medio con la IA ayudando en la lucha contra la nueva pandemia por COVID-19. Los programas de Inteligencia Artificial bien diseñados pueden ayudar a los gobiernos a garantizar que los servicios que se presten al segmento de la población que más los necesita.

Por otro lado, la IA también se está utilizando para una amplia variedad de propósitos en el sector público: desde la regulación del tráfico por carretera y la prestación de servicios médicos de emergencia hasta el orden público, el control de fronteras, la educación y la prestación de servicios. Los funcionarios del gobierno han adoptado con entusiasmo el uso de la Inteligencia Artificial, a veces con resultados e historias espectaculares.

Sin embargo, a medida que aumenta el uso de la IA en el sector público, existe una interesante contradicción entre ésta y las políticas públicas que deben abordarse.

¿Cómo crear un buen algoritmo?

La política pública, especialmente en las sociedades democráticas, se forma sobre la base de compromisos entre varios intereses en competencia. Esto es bueno para la democracia, pero el resultado exacto de una política en particular puede no estar definido con mucha precisión, ya que se trata de un compromiso entre varios resultados posibles.

Lo anterior puede plantear un problema al escribir algoritmos de IA para implementar la política. La IA, con sus redes neuronales, es esencialmente fórmulas matemáticas. Las instrucciones y los resultados imprecisos pueden dar lugar a algoritmos incorrectos.

Lo que agrava las cosas es el hecho de que la ética se ha convertido en una parte importante de la discusión sobre Inteligencia Artificial. Un temor creciente de que los sesgos sistémicos puedan infiltrarse en los algoritmos de IA, especialmente en los casos en que estas redes de IA funcionan de forma autónoma sin intervención humana, ha dado lugar a la demanda de explicaciones. Debe haber información clara sobre lo que están haciendo los programas, por qué lo están haciendo y para quién.

El Modelo de Marco de Gobernanza de la IA de Singapur, por ejemplo, tiene dos principios rectores que establecen, por un lado, que las decisiones tomadas por la IA deben ser “explicables, transparentes y justas” y, por otro, que los sistemas de IA deben estar centrados en el ser humano (es decir, el diseño y la implementación de esta tecnología debe proteger los intereses de las personas, incluida su seguridad y bienestar).

No puede haber ningún compromiso con la idea de que los algoritmos de Inteligencia Artificial no deberían tener un sesgo sistémico, pero esto presenta un problema en el sentido de que los programas complejos de IA funcionan mejor en forma de “caja negra”. La explicabilidad puede ser difícil para los algoritmos complejos que son difíciles de entender y, más aún, no pueden ser explicados sin matemáticas de alto nivel.

El reto

Entonces el desafío para los funcionarios e ingenieros del sector público, que escriben el código, es que las políticas públicas pueden ser imprecisas, tanto en objetivos como en resultados. Esto debe incluirse en los programas de IA que requieren objetivos y resultados muy precisos y claramente definidos.

No obstante, este no es un problema insuperable, pero en el alboroto de lo maravillosa que es la Inteligencia Artificial es fácil pasarlo por alto. El conocimiento del problema ayuda a los funcionarios del gobierno a redactar políticas en términos claros y concisos, y a explicar a los ingenieros cuáles son los resultados deseados.

¿Qué podría salir mal?

También es necesario reconocer que incluso los programas de IA mejor diseñados podrían salir mal. Y esto significa que, como en otras esferas de actividad, debemos aprender de nuestros errores.

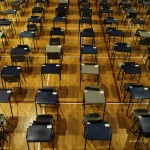

Un buen ejemplo es lo que sucedió en marzo del año pasado en el Reino Unido. Con la cancelación de los exámenes de nivel A de salida de la escuela en todo el país debido a la pandemia, el regulador del gobierno, Ofqual, desarrolló un algoritmo para determinar la clasificación de cada estudiante utilizando la información existente sobre las calificaciones de los estudiantes, las escuelas y otros datos. Este grado era importante porque determinaría a qué universidad irían dichos estudiantes.

Una vez que se realizó el proceso, se encontró que aproximadamente el 40% de la cohorte tenía sus calificaciones más bajas en comparación con sus promedios habituales y las calificaciones esperadas. Esto provocó una protesta en todo el país, en gran parte porque la metodología parecía haber exacerbado la desigualdad social al favorecer en general a los estudiantes de las escuelas privadas a expensas de sus pares del sector estatal.

La lección de esta debacle fue que no hubo mala fe por parte de quienes diseñaron el algoritmo y tampoco hubo una intención deliberada de apoyar a los estudiantes de élite de las escuelas privadas a expensas de sus compañeros más pobres que estudian en las escuelas públicas. Sin embargo, la ley de las consecuencias no deseadas se puso al día.

Los datos clave utilizados por el algoritmo fueron la evaluación de los profesores de las posibles calificaciones de los estudiantes individuales y la clasificación de cada estudiante dentro de cada materia y clase. Para garantizar que no existiera un sesgo en la evaluación de los alumnos por parte de los profesores, el algoritmo introdujo un deflactor que degradó involuntariamente muchos miles de estos resultados, particularmente en las escuelas públicas en áreas de bajos ingresos en comparación con las escuelas privadas. Esto sucedió porque si bien el estándar general de los estudiantes probablemente sería más alto en las escuelas privadas, los valores atípicos en las escuelas públicas, con el potencial de puntajes altos, fueron discriminados inadvertidamente.

¿Qué se puede rescatar?

A pesar de los problemas, la Inteligencia Artificial tiene el potencial de hacer un bien inmenso y ya se está utilizando para proporcionar algunos servicios revolucionarios, como crédito a pequeñas empresas no bancarizadas, servicios médicos a comunidades marginadas y transferencias directas de beneficios a las personas que más los necesitan. Durante la pandemia, por ejemplo, los sectores marginados de la sociedad en muchos países han recibido ayuda mediante el uso de la IA.

En última instancia, es necesario recordar que la IA puede ayudar a proporcionar una buena gobernanza, pero nunca puede ser un sustituto de la buena gobernanza. La herramienta es un medio para un fin y nunca puede ser el fin en sí mismo. La Inteligencia Artificial debe seguir siendo una de las muchas flechas del carcaj del sector público que se utilizan para proporcionar mejores servicios centrados en los ciudadanos.

Con información de GovInsider