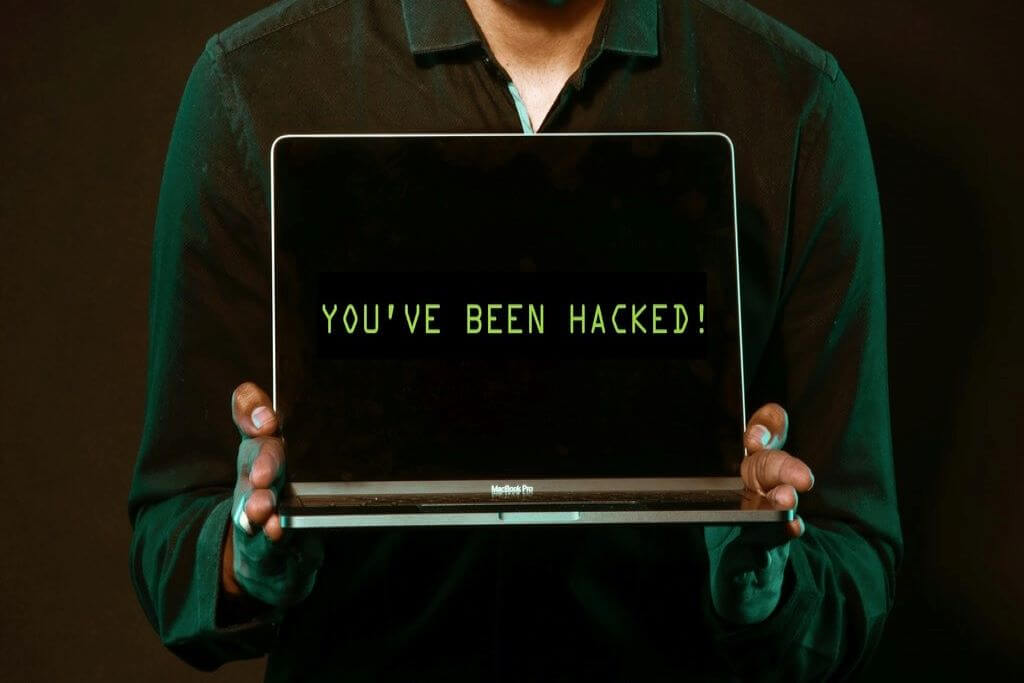

A medida que el mundo se digitaliza y las organizaciones adoptan una estrategia centrada en la nube, el enfoque tradicional de defensa del perímetro de la red de ciberseguridad, que ha sido el elemento básico durante las últimas dos décadas, ya no funciona.

El límite de la red se ha vuelto borroso y continúa creciendo y evolucionando rápidamente. Por lo general una gran empresa con proveedores, clientes y otras partes interesadas que inician sesión en su red para facilitar la actividad comercial, debe tener la capacidad de analizar con precisión todos los días varios cientos de miles de millones de señales (que varían en el tiempo) para calcular el riesgo de una infracción.

Para las organizaciones del sector público que brindan servicios centrados en los ciudadanos en línea, como portales de impuestos o tableros de fondos de previsión, la cantidad de visitas o señales que intentan comunicarse con el servidor podría ser aún mayor.

Si bien la automatización de las tareas de seguridad ha sido una característica durante algún tiempo, ya no es posible realizar un seguimiento de transacciones de gran volumen o visitas con herramientas tradicionales de ciberseguridad.

Los profesionales de la seguridad de la información recurren cada vez más a la Inteligencia Artificial (IA) y el aprendizaje automático (Machine learning) que automatizan la detección y respuesta de amenazas y, al mismo tiempo, garantizan la facilidad de acceso a las redes.

Estas nuevas herramientas críticas pueden analizar e identificar amenazas que van desde vulnerabilidades de día cero hasta ataques sofisticados de ransomware y comportamientos riesgosos, incluso de fuentes confiables, que podrían conducir a un ataque de phishing o la descarga de APT (Amenazas Persistentes Avanzadas) basadas en códigos maliciosos.

Claro que la IA y el aprendizaje automático son herramientas poderosas para el bien en manos de los profesionales de la ciberseguridad, pero su uso malintencionado es también la mayor amenaza a la que se enfrenta la seguridad digital en la actualidad.

Los delincuentes pueden utilizar las herramientas de Inteligencia Artificial para lanzar vectores de amenazas con una velocidad sobrehumana, comprometer los servicios públicos y lanzar campañas de desinformación automatizadas y diseñadas específicamente para derribar la moral de la sociedad.

Posible mal uso

El posible uso indebido de la IA debe tenerse en cuenta cuando los gobiernos y las organizaciones de todo el mundo formulan políticas y construyen y gestionan su infraestructura digital. Se requiere la formulación de políticas a nivel institucional para garantizar el diseño y la distribución de sistemas de Inteligencia Artificial con salvaguardas integradas en estas plataformas.

Las herramientas de ciberseguridad basadas en IA se destacan porque se pueden programar para aprender de ataques pasados y anticipar posibles nuevos. La Inteligencia Artificial puede estudiar los historiales de comportamiento, crear automáticamente perfiles de usuarios, activos y redes. Esto les permite detectar y responder automáticamente a las desviaciones de las normas establecidas.

Tradicionalmente, todos los programas de IA son “entrenados” al proporcionales datos para que puedan reconocer patrones para predecir el comportamiento futuro basándose en el “comportamiento pasado” observado.

Cuantos más datos se introducen en el programa, más información se tiene para predecir con precisión. Esa es la razón por la que los programas de IA mejoran en lo que hacen, a medida que pasa el tiempo.

Un problema interesante al que se enfrentan los investigadores al “entrenar” los programas de Inteligencia Artificial para la ciberseguridad es que, dentro de una organización, generalmente hay más datos sobre lo que se puede interpretar como un comportamiento “normal” que sobre el comportamiento “anormal”.

Esto presenta un interesante conjunto de problemas para los expertos en ciberseguridad. Si bien los patrones de ataque pasados podrían usarse como datos de entrenamiento, muy rara vez los piratas informáticos repiten la metodología utilizada en un ataque anterior porque anticipan que se ha configurado una defensa para ese tipo de ataque.

Entrenamiento de IA

Como resultado, enseñar a los programas de Inteligencia Artificial a distinguir entre el comportamiento “bueno” y el comportamiento “malo” no siempre funciona. En cambio, lo que hacen la mayoría de los investigadores de ciberseguridad es enseñar a la IA a comprender en qué consiste un comportamiento normal para cualquier nodo en particular dentro de la red. Una vez que estén capacitados en esto, los programas pueden buscar desviaciones de este “comportamiento normal”.

Y es que la mayoría de los programas de IA tienen muchas capas de sofisticación incorporadas, al menos en el nivel más fundamental, por lo que inmediatamente señalan cualquier cosa diferente de lo que debería ser dicho comportamiento normal. El punto importante aquí es que el comportamiento anormal puede no significar necesariamente que se esté produciendo un ataque en el sistema.

Un ejemplo simple de un comportamiento anormal, pero “no malicioso” podría ser un empleado que accede a una base de datos en particular con una computadora que nunca se ha utilizado para acceder a la base de datos. Es muy posible que el acceso se deba a nuevos requisitos laborales, al igual que también podría significar que la identidad del empleado se ha visto comprometida y el acceso es con la intención de exfiltrar datos.

En una organización en la que varios cientos de miles de millones de señales rebotan dentro de la red, el programa de Inteligencia Artificial puede señalar instantáneamente un comportamiento anormal en el que momento en que ocurre, una hazaña que no es posible para los humanos. Esto permite un seguimiento rápido.

Como se mencionó anteriormente, uno de los problemas más intratables de la ciberseguridad es que tanto los profesionales como los piratas informáticos tienen el mismo acceso a la tecnología y una comprensión igual de cómo funciona.

Dado que la IA generalmente está programada para señalar el comportamiento que es una desviación de la norma aceptada, los piratas informáticos saben lo que buscan los expertos en seguridad e intentan adaptar su ataque de tal manera que se mantenga dentro de los límites del comportamiento normal para no despertar sospechas.

Los profesionales de la ciberseguridad, por su parte, entienden esto y es por eso que los investigadores combinan la teoría de juegos con los programas de Inteligencia Artificial y aprendizaje automático para adivinar a los piratas informáticos. Todo se reduce a un juego del gato y el ratón.

Ampliando los ataques

Así como la IA ha demostrado ser una herramienta invaluable para los profesionales de la ciberseguridad, también ha facilitado mucho el trabajo de los piratas informáticos. La capacidad de escalar las operaciones utilizando IA ha permitido que muchos grupos de ciberatacantes completen tareas que normalmente requerirían inteligencia y experiencia en software del más alto nivel.

La piratería solía ser el dominio exclusivo de los ingenieros de software de gran talento. Sin embargo, con la automatización que permiten las herramientas de Inteligencia Artificial, los ciberdelincuentes ya no necesitan ni siquiera ser ingenieros de software.

Esto ha aumentado el grupo de actores maliciosos, así como la frecuencia de tales ataques, porque el costo de cada ataque ha bajado. El aumento global de los ciberataques observado desde el brote de la nueva pandemia de coronavirus el año pasado podría atribuirse, al menos en parte, al aumento de la automatización mediante el uso de herramientas de IA.

Muchos investigadores de seguridad creen que el uso cada vez mayor de la Inteligencia Artificial por parte de ciberdelincuentes permitirá ataques más precisos y difíciles de atribuir. No habrá forma de saber qué sistemas son vulnerables y están comprometidos.

Para complicar aún más las cosas, esto llega en un momento en que las organizaciones se están volviendo rápidamente digitales. Muchos no tienen los medios para mantener la ciberseguridad en el centro de su viaje digital.

El gobierno tiene un papel importante que desempeñar para garantizar un mundo en red seguro. Los responsables de la formulación de políticas deben colaborar estrechamente con los investigadores técnicos para investigar, prevenir y mitigar los posibles usos maliciosos de la Inteligencia Artificial.

Al igual que las tecnologías militares de doble uso, como los motores de avión y los radares, los responsables de la formulación de políticas de IA, los investigadores y los científicos deben comprender la naturaleza de doble uso de su tecnología. Esto garantizará que los mismos protocolos de seguridad estándar, utilizados para las tecnologías militares de doble uso, también se apliquen a las herramientas basadas en Inteligencia Artificial.

No obstante, esto será más fácil decirlo que hacerlo, ya que gran parte de la investigación de vanguardia en IA y aprendizaje automático se realiza a través de la colaboración de Código Abierto que da acceso a todos.

Se requiere una conciencia total, tanto del lado de la formulación de políticas como de la comunidad científica, para garantizar que la IA siga siendo una fuerza del bien y no una herramienta utilizada para destruir la red digital global que prospera en el acceso abierto y la colaboración.

Los investigadores de Inteligencia Artificial y las organizaciones que los emplean se encuentran en una posición única para dar forma al panorama de seguridad del mundo habilitado por IA.

Con información de GovInsider